로컬 기반 LLM을 활용한 자막 번역 시스템 사용 방법

- Develop/Release

- 2025. 6. 26.

로컬 환경에서 LLM을 활용한 자막 번역 시스템을 구축하기 위해, 다음과 같은 준비가 필요합니다. 이 과정은 기술에 익숙하지 않더라도 누구나 따라 할 수 있도록 구성되어 있습니다.

로컬 기반 LLM을 활용한 자막 번역 시스템 구축

개요기존에는 Papago API나 DeepL과 같은 외부 번역 API를 활용해 자막 파일을 번역해왔습니다. 이들 서비스는 번역 품질이 우수하지만, 대부분 일정량의 무료 크레딧이 일일 혹은 월 단위로 제한되

www.vbflash.net

🧰 필요한 도구

1. LM Studio

- 오픈소스 기반의 LLM 실행 도구로, 다양한 로컬 모델을 쉽게 불러와 사용할 수 있습니다.

- GUI 기반이라 설치 및 사용이 간편하며, REST API 서버 활성화도 지원합니다.

2. Local LLM 모델

- 사용자가 원하는 번역용 LLM 모델을 선택하여 다운로드할 수 있습니다.

- 예: EXAONE, LLaMA, DeepSeek, Mistral 등

3. 환경설정 파일

- setting.env: LLM REST API와 관련된 기본 설정값을 포함

- prompt_template.txt: 번역 시 사용할 기본 프롬프트 템플릿

- filename_prompt_template.txt: 자막 파일 구조를 인식시키기 위한 프롬프트 템플릿

번역(SubLLM) 실행 Part (요약)

📂 첨부파일 구성

아래는 제공된 번역 시스템 폴더의 구조입니다:

├── Local_LLM_R01.exe # 실행파일

├── prompt_template.txt # 번역 프롬프트 템플릿

├── filename_prompt_template.txt # 파일명 번역용 프롬프트

├── setting.env # 환경설정 파일

├── subtitles/ # 원본 자막 파일 넣는 폴더

└── output/ # 번역 결과 저장 폴더 (자동 생성)

⚙️ 환경설정 및 번역 절차

1. LM Studio 설치

- 공식 웹사이트: https://lmstudio.ai/

- 설치 후, 사용하려는 LLM 모델 다운로드 및 로드

2. LLM 모델 설정

- 권장 모델: lgai-exaone/exaone-3.5-2.4b-instruct

- 모델 로드 후 REST API 활성화

- 외부/내부 요청을 모두 허용하도록 설정

3. 프롬프트 파일 구성

- prompt_template.txt: 번역 품질을 위한 메시지 템플릿

- filename_prompt_template.txt: 파일명 생성용 프롬프트

- ⚠️ LLM이 생성한 파일명이 잘못될 수 있으므로 확인 필요

4. 번역 실행

- Local_LLM_R01.exe 파일 실행

- 터미널이 활성화되며 번역 진행 상태를 실시간 확인 가능

- subtitles 폴더에 자막 파일(SRT/VTT 등)을 넣으면 자동 처리됨

- 결과는 output 폴더에 저장됨

다운로드 링크 (아래 클릭)

SUBLLM R01 Download

번역(SubLLM) 실행 Part

⚙️ LM Studio 설치 및 설정 방법

1. LM Studio 다운로드 및 설치

아래 공식 사이트에서 LM Studio를 다운로드하여 설치합니다.

👉 https://lmstudio.ai/

2. 모델 다운로드 및 선택

- LM Studio를 실행한 뒤, 돋보기 아이콘(검색) 메뉴로 이동합니다.

2. 원하는 모델을 검색하고, 하드웨어 성능에 맞는 모델을 선택하여 다운로드합니다.

예시:

본 포스팅에서는 EXAONE-3.5-2.4B-Instruct-GGUF 모델을 사용하였습니다.

이 모델은 6GB VRAM에서도 무리 없이 실행 가능하며, 중급 수준의 번역 품질을 제공합니다.

✅ Tip: VRAM이 12~16GB 이상이라면 더 큰 모델을 선택해도 좋습니다.

예: Mistral-7B, Gemma-7B, LLaMA2-13B 등

3. 모델 로딩 및 REST API 활성화

- 상단의 [Develop] 탭으로 이동합니다.

- 다운로드한 모델을 선택한 후, VRAM에 로드(Upload) 합니다.

(로드하는 데 수 분 정도 소요될 수 있습니다.) - 모델 로딩이 완료되면 좌측 상단의 [Status: Stopped] 버튼을 클릭하여 [Status: Running] 상태로 전환합니다.

4. REST API 접속 확인

모델이 실행 중이라면 아래와 같은 주소로 접속할 수 있습니다:

http://<사용자 IP>:1234

예: http://192.168.29.191:1234

브라우저에서 해당 주소에 접속했을 때 다음과 같은 페이지가 나타나야 합니다:

- 모델 이름, 토큰 제한, 상태 정보가 표기된 REST API 문서 페이지

- 예시 요청 및 응답 예제 확인 가능

✅ 반드시 이 화면이 나와야 Python 스크립트에서 정상적으로 연결되어 번역이 수행됩니다.

📁 파일 구조 및 프롬프트 설정

- setting.env: 모델 주소(http://localhost:1234), 프롬프트 설정 등 포함

- prompt_template.txt: "다음 문장을 자연스럽고 의미가 잘 전달되도록 한국어로 번역해주세요."와 같은 지시어 포함

- filename_prompt_template.txt: 자막 형식을 고려하여, SRT 번호/시간/자막 문장을 구분하여 처리하도록 구성

이제 위 과정을 완료하면, 로컬 기반 LLM을 활용한 자막 번역 시스템을 실행할 준비가 모두 끝난 것입니다.

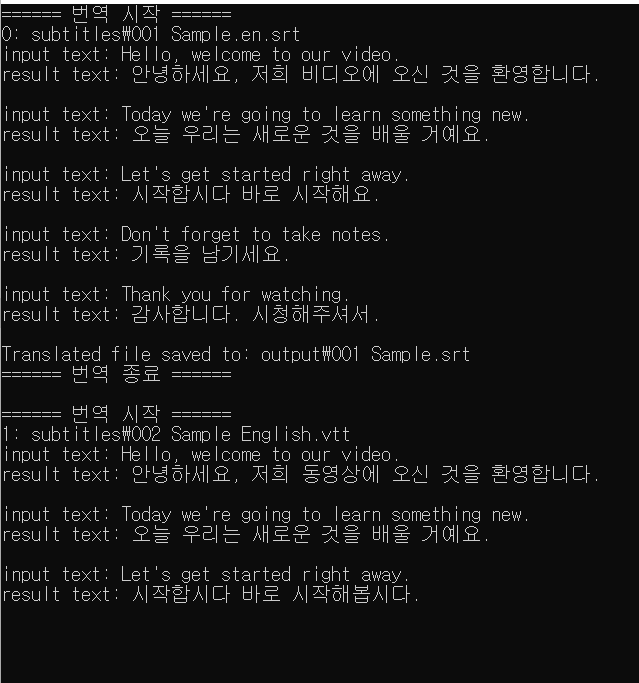

📁 실행결과

- 상단 설정이 완료되면, Subtitles 폴더에 자막 파일 넣고 실행파일(Local_LLM_R01.exe)을 실행하시면 됩니다!

끝!!

'Develop > Release' 카테고리의 다른 글

| 로컬 기반 LLM을 활용한 자막 번역 시스템 구축 (0) | 2025.06.25 |

|---|---|

| 자막(*.srt) 번역 프로그램(Kmelon Translator) v2.0.1.3 (43) | 2021.10.11 |

| 키워드(태그)를 이용한 음악파일 관리 툴 r2.1.3.2 (4) | 2020.12.30 |

| 폰트 뷰어 관리자 툴 R.105 (4) | 2020.12.20 |

| 바탕화면 자동 변경 모듈 (DesktopWallpaper) R.104 (0) | 2020.12.18 |

| 한글 인코딩 변환 작업 (0) | 2020.12.14 |

| 리소스 관리 툴 (0) | 2020.12.11 |

| 자율주행 자동차 데이터셋 관리 툴 소개 (0) | 2020.11.24 |

| Visual Studio Project Cleaner (프로젝트 청소기) (0) | 2020.11.20 |

| Visual studio에서 openCV 라이브러리 초간단 설정 방법 (0) | 2020.11.20 |